医療と医学

2023.05.03

患者さんの質問に対しChatGPTは医師より質が高く共感的な回答ができる!

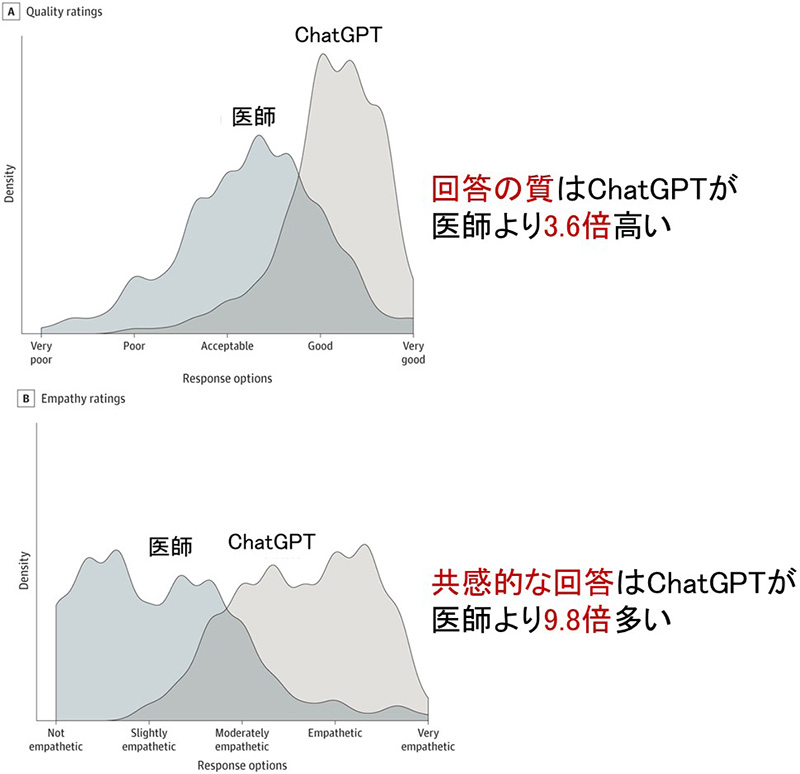

タイトルを見て「ついにこういう論文が出たか・・・」という感じがしました.JAMA Intern Med誌の論文です.話題のAIチャットボットChatGPTが,患者さんの質問に対して質の高い共感的な回答を提供できるかを評価しています.ソーシャルメディアReddit/AskDocsにおける患者さんからの質問を195個選び(例:爪楊枝を飲み込んでしまった場合,死亡する恐れがありますか?ランニング中に金属棒に頭部を打撲し,コブができて頭痛する場合,受診すべきですか?等),それらに対する回答を医師とChatGPTで比較しています.回答ごとに3通りの評価が行われ,195✕3個の評価のうち78.6%が医師よりChatGPTの回答を選んでいます.そしてChatGPTの回答は有意に長く(211語対52語,P < 0.001),かつ高品質でした(P < .001).例えば「良い」または「非常に良い」と評価された回答の割合はChatGPTの方が3.6倍多くありました(78.5%対22.1%).かつ有意に共感的で(P < .001),「共感的」または「非常に共感的」と評価された回答の割合は9.8倍!でした(45.1%対4.6%).

結論としては,臨床の場でさらなる検討が必要であるものの,ChatGPTを使って回答を作成し,医師がそれを編集することを提案しています.日本と比べ医療の電子化が進む米国では,患者さんからの電子メッセージがパンデミック前の6割増加し,医師のバーンアウトの要因となると考えられているそうで,もしランダム化比較試験にてChatGPTの有効性が証明できたら,医師のバーンアウトの抑制につながり,患者さんの転帰も改善するかもしれないと著者は前向きに語っています.

論文に「共感(empathy)」という言葉を見つけたため,とても注目して読みました.というのは,私は医学生に「医療者として難病患者さんに向き合う態度はsympathy(同情)ではなく,empathy(共感)が大切である」と教えているためです.「共感の授業(https://amzn.to/3owxl8f)」という本では,「共感は本能ではない.生まれたときから固定の才能ではなく,意識的に伸ばすことのできるスキルである」と述べています.共感,つまり人を思いやる教育をしっかり行っていかないと,患者さんへの病状説明も早晩,ChatGPTにお願いすることになるかもしれません.

Ayers JW, et al. Comparing Physician and Artificial Intelligence Chatbot Responses to Patient Questions Posted to a Public Social Media Forum. JAMA Intern Med. 2023 Apr 28:e231838.(doi.org/10.1001/jamainternmed.2023.1838)